Untertitel sind eine effektive Methode, um die Zugänglichkeit, die Interaktion und die Informationsspeicherung bei Präsentationen und Live-Veranstaltungen zu verbessern. Dies, zusammen mit den veränderten Videokonsumgewohnheiten im Bereich Videostreaming, hat die Nutzung KI-gestützter Untertitelung bei Live-Veranstaltungen und Geschäftstreffen in letzter Zeit beschleunigt.

Doch wenn es darum geht, einen Anbieter für Ihre eigene Besprechung oder Veranstaltung auszuwählen, lautet die am häufigsten gestellte Frage: Wie genau sind automatische Live-Untertitel?

Die kurze Antwort lautet: Unter idealen Bedingungen können automatische Untertitel in gesprochenen Sprachen eine Genauigkeit von bis zu 98 % erreichen, gemessen an der Wortfehlerrate (WER).

Und ja, die Antwort ist etwas ausführlicher und komplexer. In diesem Artikel möchten wir Ihnen einen Überblick darüber geben, wie Genauigkeit gemessen wird, welche Faktoren die Genauigkeit beeinflussen und wie Sie diese weiter steigern können.

In diesem Artikel

- Wie automatische Untertitelung funktioniert

- Was gilt als gute Untertitelqualität?

- Welche Faktoren beeinflussen die Genauigkeit?

- Messung der Genauigkeit automatischer Untertitelung

- Wortfehlerrate (WER) verstehen

- Erhalten Sie unglaublich präzise Untertitel für Ihre Live-Veranstaltungen

Bevor wir uns mit den Zahlen befassen, werfen wir einen Schritt zurück und schauen uns an, wie automatische Untertitel funktionieren.

Wie automatische Untertitelung funktioniert

Automatische Untertitel

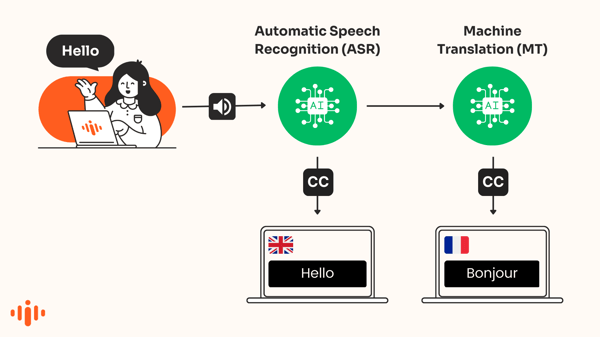

Automatische Untertitel wandeln gesprochene Sprache in Text um, der in Echtzeit in der gleichen Sprache wie die gesprochene Sprache auf dem Bildschirm angezeigt wird. ASR (Automatische Spracherkennung) ist eine Form künstlicher Intelligenz, die zur Erstellung dieser Transkripte gesprochener Sätze verwendet wird.

Die Technologie, oft auch als „Sprache-zu-Text“ bezeichnet, erkennt automatisch Wörter in Audioaufnahmen und transkribiert die Stimme in Text.

KI-übersetzte Untertitel

KI-gestützte Übersetzungsprogramme übersetzen automatisch Untertitel, die in einer anderen Sprache vorliegen. Dies wird auch als maschinell übersetzte Untertitel bezeichnet.

Empfohlener Artikel

Warum Sie bei Ihrer nächsten Veranstaltung Live-Untertitel in Betracht ziehen sollten

In diesem Artikel geht es um automatische Untertitel. Informationen zur Genauigkeit KI-generierter Untertitel finden Sie in diesem Artikel .

Was gilt als gute Untertitelqualität?

Die Federal Communications Commission (FCC) hat im Jahr 2014 wesentliche Merkmale festgelegt, anhand derer beurteilt werden kann, ob Untertitel „ausgezeichnet“ sind:

- Genauigkeit – Die Untertitel müssen so genau wie möglich mit den gesprochenen Worten übereinstimmen.

- Vollständigkeit – Die Untertitel laufen vom Anfang bis zum Ende der Sendung, soweit dies möglich ist.

- Platzierung – Die Untertitel verdecken keine wichtigen visuellen Inhalte und sind gut lesbar.

- Synchronisation – Die Untertitel sind mit der Audiospur synchronisiert und erscheinen in einer gut lesbaren Geschwindigkeit.

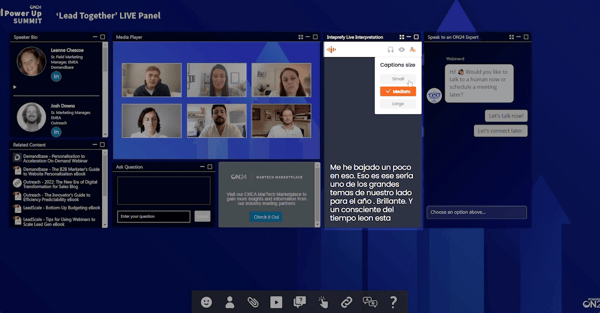

Bild: KI-übersetzte Live-Untertitelung während eines Webinars

Welche Faktoren beeinflussen die Genauigkeit?

Die ausgewählte KI-Engine

Nicht alle Spracherkennungssysteme liefern identische Ergebnisse. Manche sind generell besser, andere eignen sich besser für bestimmte Sprachen. Selbst bei Verwendung desselben Systems können die Ergebnisse je nach Akzent, Geräuschpegel, Thema usw. stark variieren.

Deshalb vergleichen wir bei Interprefy ständig führende Engines, um diejenigen zu ermitteln, die die präzisesten Ergebnisse liefern. So kann Interprefy Nutzern die optimale Lösung für eine bestimmte Sprache bieten und dabei Aspekte wie Latenz und Kosten berücksichtigen. Unter idealen Bedingungen haben wir für verschiedene Sprachen eine durchgängige Genauigkeit von bis zu 98 % erzielt.

Die Audioeingangsqualität

Für eine optimale Ausgabe der automatisierten Spracherkennung ist eine hohe Eingangsqualität unerlässlich. Ganz einfach: Je höher die Qualität und Klarheit des Audio- und Sprachmaterials, desto besser das Ergebnis.

- Audioqualität - Ähnlich wie beim Konferenzdolmetschen kann minderwertige Audioeingabehardware, wie z. B. eingebaute Computermikrofone, einen negativen Einfluss haben.

- Deutliche Aussprache – Moderatoren, die laut, in einem angemessenen Tempo und deutlich sprechen, werden in der Regel mit höherer Genauigkeit untertitelt .

- Hintergrundgeräusche wie lautes Rumpeln, Hundegebell oder Papierrascheln, die vom Mikrofon aufgenommen werden, können die Qualität der Audioeingabe erheblich beeinträchtigen.

- Akzente – Sprecher mit ungewöhnlichen oder starken Akzenten sowie Nicht-Muttersprachler stellen für viele Spracherkennungssysteme ein Problem dar.

- Überlappendes Sprechen – Wenn zwei Personen durcheinanderreden, hat das System große Schwierigkeiten, den richtigen Sprecher korrekt zu erkennen.

Empfohlener Artikel

Wie genau sind die Untertitel in Zoom, Teams und Interprefy?

Wie man die Genauigkeit automatischer Untertitel misst

Die am häufigsten verwendete Kennzahl zur Messung der Genauigkeit der automatischen Spracherkennung (ASR) ist die Wortfehlerrate (WER), bei der das tatsächliche Transkript des Sprechers mit dem Ergebnis der ASR-Ausgabe verglichen wird.

Wenn beispielsweise 4 von 100 Wörtern falsch sind, beträgt die Genauigkeit 96 %.

Wortfehlerrate (WER) verstehen

WER bestimmt den kürzesten Abstand zwischen einem von einem Spracherkennungssystem generierten Transkript und einem von einem Menschen erstellten Referenztranskript (der Ground Truth).

Die Worterkennungsrate (WER) gleicht korrekt identifizierte Wortfolgen auf Wortebene ab, bevor die Gesamtzahl der Korrekturen (Ersetzungen, Löschungen und Einfügungen) berechnet wird, die für die vollständige Angleichung von Referenz- und Transkripttext erforderlich sind. Die WER wird dann als Verhältnis der benötigten Anpassungen zur Gesamtwortzahl des Referenztextes berechnet. Eine niedrigere WER deutet im Allgemeinen auf ein genaueres Spracherkennungssystem hin.

Beispiel für eine Fehlerrate bei einzelnen Wörtern: 91,7 % Genauigkeit

Nehmen wir als Beispiel eine Wortfehlerrate von 8,3 % – oder eine Genauigkeit von 91,7 % – und vergleichen wir die Unterschiede zwischen dem Originaltranskript der Rede und den von ASR erstellten Untertiteln:

| Originaltranskript: | Ausgabe von ASR-Untertiteln: |

| möchte beispielsweise wesentlichen Punkten Gebrauch machen. Wenn ich auf einen bestimmten Punkt genauer eingehen möchte, befürchte ich, dass die Aufforderung an die einzelnen Landesparlamente, das Übereinkommen erst zu ratifizieren, nachdem die Rolle des Europäischen Gerichtshofs geklärt wurde, sehr nachteilige Auswirkungen haben könnte. | Zum Beispiel möchte auch Ausnahmen nur in sehr begrenztem Umfang genutzt werden. Ich möchte auf einen bestimmten Punkt genauer eingehen. Ich befürchte, dass die Aufforderung an die einzelnen Landesparlamente, das Übereinkommen erst nach Klärung der Rolle des Europäischen Gerichtshofs zu ratifizieren, sehr nachteilige Auswirkungen haben könnte. |

In diesem Beispiel fehlte in den Bildunterschriften ein Wort und wurde durch vier Wörter ersetzt:

- Kennzahlen: {'Übereinstimmungen': 55, 'Löschungen': 1, 'Einfügungen': 0, 'Ersetzungen': 4}

- Ersetzungen: [('too', 'do'), ('use', 'used'), ('exemptions', 'essentials'), ('the', 'i')]

- Löschungen: ['würde']

Die Berechnung der Wortfehlerrate erfolgt daher wie folgt:

WER = (Deletionen + Substitutionen + Insertionen) / (Deletionen + Substitutionen + Übereinstimmungen) = (1 + 4 + 0) / (1 + 4 + 55) = 0,083

WER vernachlässigt die Art der Fehler

Im obigen Beispiel haben jedoch nicht alle Fehler die gleichen Auswirkungen.

Die WER-Messung kann irreführend sein, da sie keine Auskunft darüber gibt, wie relevant oder wichtig ein bestimmter Fehler ist. Einfache Fehler, wie beispielsweise die alternative Schreibweise desselben Wortes (movable/moveable), werden vom Leser oft nicht als Fehler wahrgenommen, während eine Ersetzung (exemptions/essentials) deutlich schwerwiegendere Folgen haben kann.

Die Worterkennungsrate (WER), insbesondere bei hochpräzisen Spracherkennungssystemen, kann irreführend sein und entspricht nicht immer der menschlichen Wahrnehmung von Korrektheit. Für Menschen sind Unterschiede zwischen einer Genauigkeit von 90 % und 99 % oft schwer zu erkennen.

Wahrgenommene Wortfehlerrate

Interprefy hat eine eigene, sprachspezifische ASR-Fehlermetrik namens „Wahrgenommene Wortfehlerrate“ (Perceived WER) entwickelt. Diese Metrik berücksichtigt nur Fehler, die das menschliche Sprachverständnis beeinträchtigen, und nicht alle Fehler. Wahrgenommene Fehler sind in der Regel niedriger als die Wortfehlerrate (WER), manchmal sogar um bis zu 50 %. Eine wahrgenommene Wortfehlerrate von 5–8 % ist für den Nutzer üblicherweise kaum wahrnehmbar.

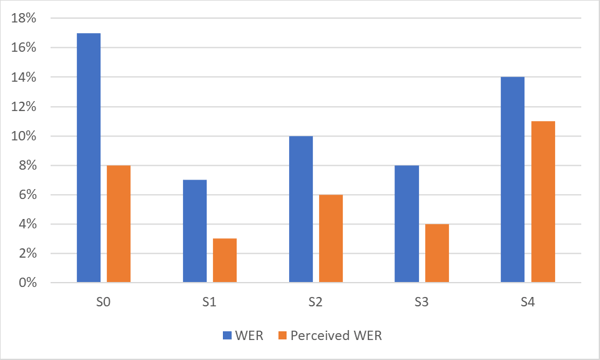

Die folgende Grafik zeigt den Unterschied zwischen Worterkennungsrate (WER) und wahrgenommener Worterkennungsrate (WER) für ein hochpräzises ASR-System. Beachten Sie die Leistungsunterschiede bei verschiedenen Datensätzen (S0–S4) derselben Sprache.

Wie aus der Grafik hervorgeht, ist die von Menschen wahrgenommene Wortfehlerrate (WER) oft wesentlich besser als die statistische Wortfehlerrate (WER).

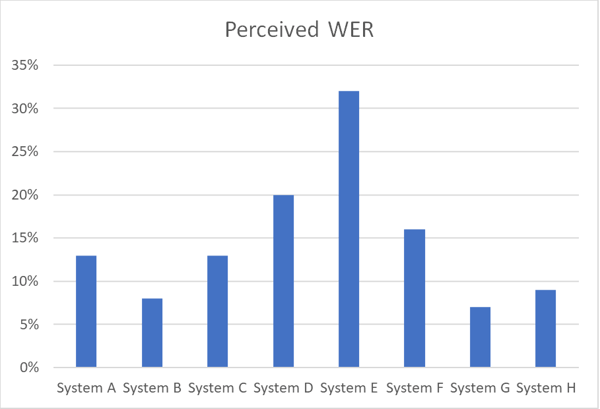

Die folgende Tabelle veranschaulicht die Genauigkeitsunterschiede zwischen verschiedenen ASR-Systemen, die mit demselben Sprachdatensatz in einer bestimmten Sprache arbeiten, unter Verwendung der wahrgenommenen Wortfehlerrate (WER).

Erhalten Sie unglaublich präzise Untertitel für Ihre Live-Veranstaltungen

Dank unserer einzigartigen technischen Lösung und unserer kundenorientierten Arbeitsweise erreichen wir bei unseren automatischen Untertiteln eine Genauigkeit von 97 %. Alexander Davydov, Leiter KI-Entwicklung bei Interprefy

Wenn Sie während einer Veranstaltung hochpräzise automatische Untertitel benötigen, sollten Sie drei wichtige Punkte beachten:

Nutzen Sie eine erstklassige Lösung

Anstatt irgendeine Standard-Engine zu wählen, die alle Sprachen abdeckt, sollten Sie sich für einen Anbieter entscheiden, der für jede Sprache Ihrer Veranstaltung die beste verfügbare Engine einsetzt.

Sie möchten wissen, was Ihnen die beste Engine bieten kann? Lesen Sie unseren Artikel: Die Zukunft der Live-Untertitel: Wie Interprefy AI die Barrierefreiheit verbessert

Optimieren Sie den Motor

Wählen Sie einen Anbieter, der die KI mit einem maßgeschneiderten Wörterbuch ergänzen kann, um sicherzustellen, dass Markennamen, ungewöhnliche Namen und Akronyme korrekt erfasst werden.

Gewährleisten Sie eine hohe Audioqualität beim Eingangssignal.

Bei schlechter Audioqualität kann das ASR-System keine zufriedenstellende Ausgabequalität erreichen. Stellen Sie sicher, dass die Sprache laut und deutlich erfasst wird.

Möchten Sie Ihre eigene Qualitätsbewertung für KI-Untertitel durchführen?

Weitere Download-Links

Weitere Download-Links